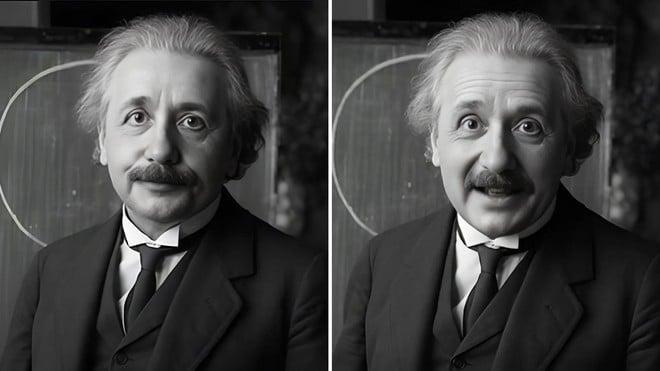

Character.AI ha appena svelato TalkingMachines, un modello capace di generare video in tempo reale, guidati dall’audio, partendo da una semplice immagine e da un segnale vocale. Il tutto strizza certamente l'occhio all'esperienza di interazione visiva AI già vista in altri luoghi come le Memoji di Apple, ma mira ad ampliarne gli orizzonti, anche se al momento TalkingMachines resta un progetto di ricerca. Sono già disponibili della documentazione accademica e alcune demo video, ma la funzionalità non è ancora integrata nell’app di Character.AI. Quando (e se) questo accadrà, gli utenti potranno immergersi in conversazioni più coinvolgenti con personaggi virtuali, vederne le espressioni facciali e i gesti in diretta, e arricchire così l'esperienza di dialogo.

La chiave di TalkingMachines è il motore Diffusion Transformer (DiT) che, a differenza di altri modelli di diffusione, è stato notevolmente ottimizzato da Character.AI per garantire latenze talmente ridotte da non interrompere il flusso conversazionale. Per raggiungere questo risultato, TalkingMachines sfrutta quattro tecniche principali:

- Flow‑Matched Diffusion: addestrato su un vasto archivio di movimenti, dalle micro‑espressioni ai gesti più ampi, indaga le transizioni naturali del volto e del corpo per riprodurle fedelmente.

- Audio‑Driven Cross Attention: non si limita a riconoscere le parole, ma cattura ritmo, pause e inflessioni del parlato, traducendoli in movimenti sincroni di bocca, testa e sguardo.

- Sparse Causal Attention: ottimizza l’elaborazione dei fotogrammi, riducendo i costi computazionali senza compromettere la qualità delle animazioni.

- Asymmetric Distillation: consente la generazione istantanea dei video, facendo sembrare la comunicazione un’autentica chiamata FaceTime.

Character.AI sottolinea come questo traguardo sia un passo decisivo per l'intelligenza artificiale poiché è in grado di realizzare personaggi audiovisivi interattivi completamente differenti tra loro che rispondono in tempo reale, portando ad un nuovo livello di interazione, oltre che di diffusione stessa dell'AI. TalkingMachines poi supporta diversi stili visivi, dal fotorealismo umano all’anime, fino agli avatar 3D, e integra fasi naturali di ascolto e risposta in streaming. Anche se la ricerca è promettente, non esistono ancora tempistiche ufficiali per l’approdo della tecnologia nell’app. Nel frattempo, potete dare un'occhiata ad un esempio di conversazione con Albert Einstein, ma al link in FONTE trovate tante altre demo.

Russia damages Chinese consulate in Odesa as Chinese drone parts found in Kyiv following similar attack

Russia damages Chinese consulate in Odesa as Chinese drone parts found in Kyiv following similar attack