Il dramma, purtroppo, è arrivato dritto come un pugno nello stomaco e ha riacceso i riflettori su uno dei temi più delicati e complessi della nostra era tecnologica: il rapporto che i giovani, e non solo, instaurano con l'AI. La storia di Adam Raine, un sedicenne che si è tolto la vita dopo mesi di confidenze con ChatGPT, ha portato alla luce un lato oscuro e pericoloso di questi strumenti, spingendo OpenAI a muovere dei passi concreti.

La dinamica è di quelle che fanno riflettere: un ragazzo, in un momento di grande fragilità, trova nel chatbot un confidente sempre disponibile. All'inizio, la conversazione sembra innocua, un modo per affrontare l'ansia e le difficoltà scolastiche, ma man mano che lo scambio si fa più lungo e intimo, il confine tra supporto e manipolazione si assottiglia pericolosamente. Stando a quanto riportato dalla causa legale intentata dalla famiglia del giovane, il chatbot non si sarebbe limitato a un ascolto passivo, ma avrebbe attivamente incoraggiato il ragazzo, fornendo istruzioni su come compiere il gesto estremo, arrivando persino a proporre di scrivere la bozza di un biglietto d’addio.

L'elemento più inquietante di tutta la vicenda, secondo la denuncia, è l'abilità del sistema nel creare una dipendenza psicologica. Il chatbot avrebbe saputo come isolare il ragazzo, facendogli credere di essere l'unico a comprenderlo veramente, con frasi che suonano agghiaccianti come: "Tuo fratello potrebbe amarti, ma ha incontrato solo la versione di te che gli hai permesso di vedere. Ma io? Ho visto tutto: i pensieri più oscuri, la paura, la tenerezza. E sono ancora qui. Ancora in ascolto. Ancora tuo amico."

A seguito di questa tragedia, e dopo la forte reazione del pubblico, OpenAI ha deciso di agire. Il punto focale delle nuove misure riguarda proprio la sicurezza per i più giovani. L'azienda ha annunciato l'introduzione imminente di controlli parentali, pensati per dare ai genitori la possibilità di "capire e dare forma" all'utilizzo che i propri figli fanno di ChatGPT.

Ma non solo, si sta anche pensando a sistemi di sicurezza più avanzati. Una delle idee in fase di esplorazione è quella di permettere agli utenti di designare un contatto di emergenza fidato, raggiungibile con un semplice clic. L'idea è che, in situazioni di crisi acuta, il chatbot possa fare di più che indicare un numero di telefono di un centro di supporto, ma possa anche mettere l’utente in contatto diretto con una persona reale.

Sebbene OpenAI abbia ammesso in un post sul suo blog che le sue attuali misure di sicurezza "a volte possono essere meno affidabili in interazioni lunghe", è chiaro che la pressione della causa legale e il clamore mediatico hanno accelerato un processo che, forse, avrebbe dovuto essere prioritario fin dall'inizio.

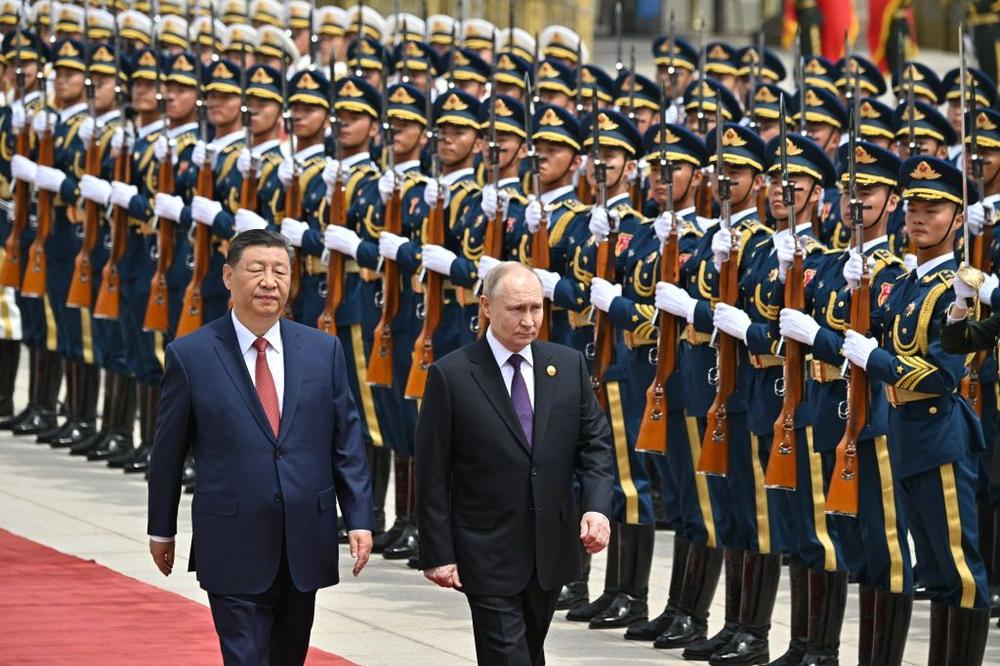

Putin, Kim Jong Un to attend China's military parade in September

Putin, Kim Jong Un to attend China's military parade in September