Cosa succederebbe se d’improvviso, per qualche ragione imperscrutabile, il mondo non fosse più capace di produrre nuovi chip? Addio TSMC, Addio Intel, Addio Samsung Foundries... Addio perfino alla cinese SMIC. La ricercatrice di Google nota su Twitter come LaurieWired ha chiesto questa domanda, che sembra un po’ un incipit per uno show TV sci-fi distopico, al mondo tramite un tweet qualche ora fa, provando a immaginare la risposta, e ha scatenato un bel po’ di discussione, alla quale è intervenuto anche nientemeno che John Carmack, il mitico programmatore di id Software e papà di Doom (di cui peraltro oggi esce il nuovo capitolo, The Dark Ages!) che è stato una figura chiave nello sviluppo dei motori grafici 3D ai bei tempi.

La teoria di LaurieWired è che, con il passare del tempo, solo i sistemi più vecchi sopravviverebbero. Benché sempre più sofisticati e raffinati, i chip sono anche più suscettibili a guastarsi. In questo caso entra in gioco l’equazione di Black, che è basata su modelli puramente teorici e che descrive sostanzialmente l’elettromigrazione, cioè un fenomeno in cui si riarrangiano le molecole di un elemento solido a causa di campi magnetici, che porta al degrado dei gate dei transistor, che quindi non riescono più a cambiare stato da 0 a 1.

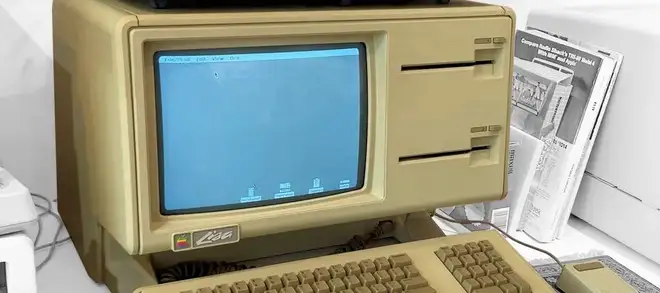

In sette anni dallo “Z-Day” (Zero-Tapeout Day, appunto il giorno in cui non escono più chip dalle fonderie) potremmo essere rimasti completamente senza smartphone, i cui chip sono i più a rischio a causa dello stress sulle saldature, e le automobili più vecchie, senza elettronica o con elettronica molto basilare, potrebbero avere assunto un valore elevatissimo. In trent’anni gli unici “computer” disponibili almeno nel mondo consumer sarebbero quelli prodotti nello scorso millennio, che hanno nodi produttivi talmente rudimentali che sarebbero in grado di rimanere operativi per secoli. Il processore Motorola 68000 di molteplici Macintosh, Atari e Amiga ha un gate wear calcolato nell’ordine dei 10.000 anni!

Ed è proprio qui che entra nella discussione Carmack, spostando l’attenzione sullo sviluppo software. La sua teoria è che in questo scenario l’ottimizzazione software tornerebbe a essere una vera priorità, e gli sviluppatori riuscirebbero a eseguire un quantitativo sorprendentemente elevato di servizi e applicazioni attuali su hardware molto datato. Addio a interpreti e microservizi, si tornerebbe a codice più monolitico e più vicino al linguaggio macchina. Certo, il ritmo di innovazione sarebbe più lento, ma si riuscirebbe comunque ad avere una parvenza di vita tecnologica/informatica.

“Di necessità virtù”, dice sostanzialmente Carmack, e non ha certo torto. In scenari meno estremi, certo, ma questo motto è stato dimostrato più e più volte anche nel mondo tecnologico. Alcune volte partendo da Carmack stesso: la prima versione di Doom per Amiga era sostanzialmente ingiocabile, poi man mano è migliorato fino a diventare più che buono, per l’epoca. E in tempi più recenti possiamo pensare a DeepSeek R1, un modello di intelligenza artificiale generativa che ottiene ottimi risultati anche se gira su hardware molto più lento e limitato rispetto a quello dei vari ChatGPT e Google Gemini, perché gli USA hanno vietato l’esportazione in Cina degli acceleratori più evoluti.

Tra gli altri dettagli interessanti ipotizzati da LaurieWired, vale la pena segnalare che probabilmente una internet globale sparirà piuttosto in fretta, perché gli switch di rete odierni non sono fatti per durare un’eternità. Addio anche agli HDD, mentre gli SSD durerebbero molto di più, ma tutti i sistemi di archiviazione a lungo termine sarebbero basati su supporti ottici.

Sound, questo è il primo diffusore senza fili di Wiim

Sound, questo è il primo diffusore senza fili di Wiim