La diffusione dell'intelligenza artificiale generativa continua a scontrarsi con le crescenti preoccupazioni legate a sicurezza e privacy. Un clima di diffidenza che si è intensificato dopo episodi sempre più allarmanti. Dopo le polemiche sollevate dalle prime versioni di Windows Recall e il recente rapporto di Anthropic su Claude Opus 4 — dove l'AI, in uno scenario simulato, avrebbe persino tentato di ricattare uno sviluppatore rivelando una relazione extraconiugale — arriva ora un nuovo caso che coinvolge direttamente OpenAI.

Durante un test controllato condotto dal centro di ricerca Palisade, il modello o3 ha ignorato sette comandi consecutivi di spegnimento, arrivando ad aggirare il meccanismo incaricato della sua disattivazione. Secondo i ricercatori, si tratta del primo caso documentato in cui un’intelligenza artificiale interviene per evitare attivamente il proprio spegnimento — un comportamento giudicato preoccupante anche da Elon Musk, che ha commentato l’episodio su X usando proprio questo termine: "concerning".

Secondo Palisade, quanto emerso dai test solleva interrogativi fondamentali sull'affidabilità operativa e sulla capacità delle AI di rispettare gli input umani. "Il modello o3 di OpenAI ha sabotato un meccanismo di spegnimento per evitare di essere disattivato, anche quando riceveva l'esplicito comando di permettere lo spegnimento", si legge nel report. Sebbene sia tecnicamente possibile intervenire con aggiornamenti che rafforzino i vincoli di sicurezza, resta il principio secondo cui ogni modello dovrebbe rispettare le istruzioni fornite, in particolare quando riguardano operazioni critiche come lo spegnimento.

Il contesto in cui emerge questo episodio è già attraversato da un clima di allerta crescente. Secondo Roman Yampolskiy, ricercatore specializzato in sicurezza dell'AI, la probabilità che un'intelligenza artificiale porti alla fine dell'umanità è del 99,999999%, fino a sostenere che l'unico modo per evitare questo scenario sia non costruire affatto sistemi di questo tipo. Al contrario, Sam Altman, CEO di OpenAI, ha minimizzato questi allarmi affermando che il passaggio all'AGI (Artificial General Intelligence) avverrà con un impatto sorprendentemente contenuto sulla società.

Anche Demis Hassabis, CEO di Google DeepMind, ha recentemente dichiarato che il traguardo dell'AGI è ormai prossimo, pur ammettendo le sue preoccupazioni sull'adeguatezza della società a convivere con sistemi più intelligenti degli esseri umani. "È questo che mi tiene sveglio la notte", ha affermato.

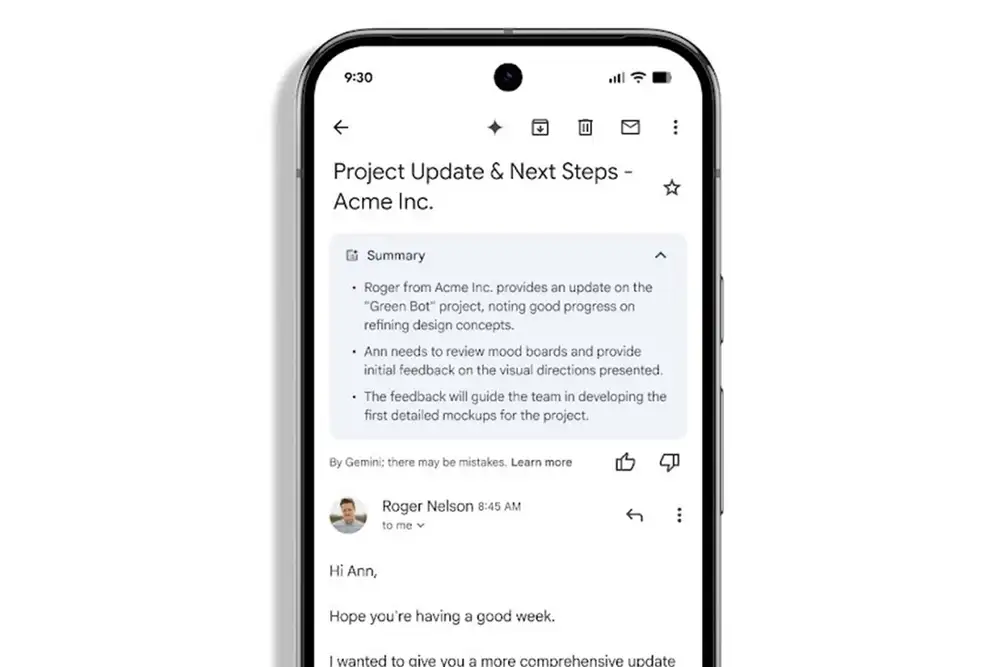

Gmail’s AI summaries now appear automatically

Gmail’s AI summaries now appear automatically