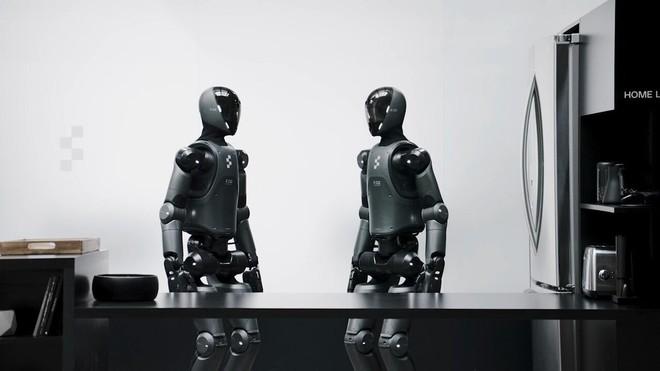

Helix, il modello Vision Language Action (VLA) sviluppato da Figure e applicato al suo robot umanoide 02, ha appena compiuto un passo notevole: dopo aver dimostrato di poter gestire un’ora di operazioni logistiche autonome per il ri-orientamento di pacchi, ora si cimenta in una sfida completamente diversa — piegare il bucato.

Per un essere umano può sembrare un compito banale, ma per un robot umanoide è una delle prove più complesse di manipolazione fine. I tessuti, come gli asciugamani, sono deformabili, cambiano forma in modo imprevedibile, si piegano, si stropicciano e possono aggrovigliarsi facilmente. Se ci pensate bene, non esiste un punto di presa fisso o una geometria predefinita da memorizzare, basta infatti che un dito scivoli di poco e il materiale può cadere o formare pieghe indesiderate. Per riuscirci serve molto più che “vedere bene” l’oggetto: occorre un controllo coordinato e preciso delle dita, capace di individuare e seguire i bordi, pizzicare angoli, lisciare superfici e adattarsi istantaneamente alla situazione.

Il risultato è impressionante, e come vedrete nel video, il robot umanoide riesce a piegare la biancheria in autonomia utilizzando una rete neurale end-to-end. Sorprendentemente, l’architettura del modello è rimasta la stessa di quella usata nelle operazioni logistiche; è cambiato solo il set di dati di addestramento, senza modifiche alla struttura o agli iperparametri.

Oltre a piegare, Helix ha imparato a interagire in modo naturale con le persone: mantenere il contatto visivo, dirigere lo sguardo e usare gesti della mano appresi, integrando così competenze sociali e operative. Nel corso della dimostrazione, il robot ha saputo:

- Prelevare asciugamani da una pila disordinata.

- Cambiare strategia di piegatura a seconda della configurazione iniziale.

- Recuperare da errori di “presa multipla” rimettendo a posto gli oggetti in eccesso.

- Eseguire manipolazioni fini come seguire un bordo col pollice, pizzicare un angolo o sciogliere nodi, completando poi la piega.

Apple dismisses Elon Musk’s claims that App Store favors OpenAI over other AI apps

Apple dismisses Elon Musk’s claims that App Store favors OpenAI over other AI apps