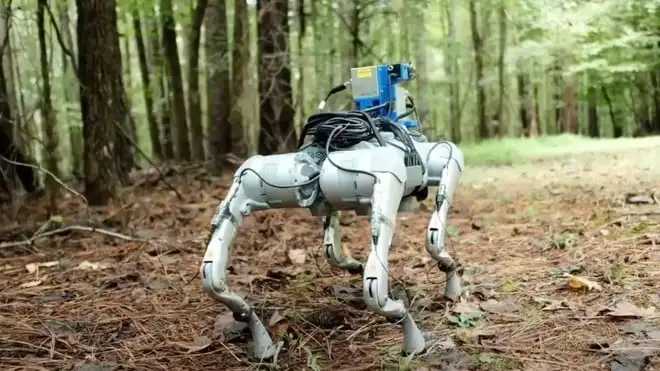

Nel cuore dei laboratori della Duke University, un gruppo di ricercatori ha lavorato un modo interessante con cui i robot possono orientarsi in ambienti complessi. Non si tratta solo di un miglioramento tecnico, ma di un passo in avanti nella percezione sensoriale delle macchine: grazie a una nuova piattaforma chiamata WildFusion, un robot quadrupede è ora in grado di “sentire” il terreno che calpesta, proprio come farebbe un essere umano.

Fino ad oggi, la stragrande maggioranza dei robot autonomi si è basata esclusivamente su telecamere e sensori LiDAR per raccogliere informazioni sul mondo circostante. Tuttavia, in ambienti naturali o disastrati, questi strumenti si rivelano spesso insufficienti. I percorsi non sono sempre chiari, i punti di riferimento possono mancare e la mappatura tridimensionale diventa difficile in presenza di dati frammentari o disturbati. WildFusion è stato concepito per affrontare proprio queste difficoltà, fondendo una varietà di input sensoriali in un’unica comprensione spaziale.

Il robot che utilizza questa tecnologia è dotato non solo di telecamere RGB e sensori LiDAR, ma anche di microfoni da contatto e sensori tattili applicati alle zampe. I microfoni rilevano le vibrazioni emesse dal terreno durante la camminata, distinguendo tra ghiaia, terra o radici. I sensori tattili, invece, forniscono informazioni sulla pressione esercitata e sull’inclinazione del corpo del robot, permettendo un costante adattamento alla superficie.

Tutti questi segnali vengono elaborati da un modello di apprendimento profondo, basato su rappresentazioni neurali implicite, che traduce i dati raccolti in una visione fluida e coerente dello spazio. Il risultato? Il robot è capace di scegliere in modo autonomo e istintivo i percorsi migliori, anche quando la vista non è sufficiente.

Il sistema è stato messo alla prova nei paesaggi variegati del parco statale Eno River, nella Carolina del Nord. Tra vegetazione fitta, sentieri irregolari e aree di ghiaia, WildFusion ha permesso al robot di muoversi in sicurezza, migliorando sensibilmente la sua capacità di prevedere la percorribilità del terreno. Per i ricercatori è stata una prova di grande soddisfazione: vederlo avanzare con sicurezza in un ambiente naturale è stato un segnale tangibile dell’efficacia della loro tecnologia.

Il potenziale applicativo di WildFusion è vasto. Dalle missioni di ricerca e soccorso in scenari pericolosi alle ispezioni in zone inaccessibili per l’uomo, questo sistema potrebbe rendere l’automazione molto più flessibile e utile nella realtà. Resta tuttavia fondamentale discutere anche le implicazioni etiche legate all’uso di robot autonomi in contesti delicati. La trasparenza e il controllo umano rimangono centrali per evitare abusi o impieghi inappropriati.

Il progetto, presentato ufficialmente all’IEEE International Conference on Robotics and Automation (ICRA 2025) ad Atlanta, rappresenta un significativo avanzamento nella robotica mobile. L’integrazione sensoriale e la capacità di adattamento potrebbero diventare standard nel prossimo futuro, rendendo i robot più consapevoli dell’ambiente in cui operano, non solo visivamente, ma anche fisicamente.

BYD Dolphin Surf vs FIAT Grande Panda, piccole a confronto: versioni e prezzi

BYD Dolphin Surf vs FIAT Grande Panda, piccole a confronto: versioni e prezzi