Quante volte ci siamo trovati in un luogo affollato o rumoroso, cercando inutilmente di farci capire da un assistente vocale? O magari in un ambiente che richiede silenzio, come una biblioteca o un ufficio, dove dettare un messaggio a voce alta sarebbe semplicemente fuori luogo. Apple sembra aver preso a cuore queste situazioni.

Un brevetto recentemente svelato, intitolato "Dispositivo elettronico con struttura per la dettatura", delinea un futuro in cui l'Apple Vision Pro potrebbe interpretare comandi e testi semplicemente leggendo le nostre labbra, senza che sia necessario emettere alcun suono. L'idea è quella di offrire un canale di comunicazione con il visore che sia discreto, privato e funzionale anche quando l'audio non è un'opzione praticabile.

Il documento, lungo ben 21 pagine, descrive un sistema sorprendentemente complesso per raggiungere questo obiettivo. Non si tratterebbe di una singola telecamera puntata sul viso, ma di una sinergia di più sensori.

Il brevetto ipotizza l'uso di un "sensore visivo trasportato dalla montatura e orientato esternamente verso il basso", specificamente progettato per rilevare il movimento della bocca. A questo si aggiungerebbe un "sensore aggiuntivo configurato per rilevare almeno una tra una vibrazione facciale o una deformazione facciale". Come se non bastasse, per confermare le selezioni si potrebbe fare affidamento su una telecamera interna che segue lo sguardo dell'utente (eye-gaze) e persino su una telecamera esterna capace di riconoscere gesti specifici della mano, usati magari per avviare o terminare la sessione di dettatura silenziosa.

Questo approccio non è del tutto nuovo per Apple, ma rappresenta un'evoluzione di concetti già esistenti. Basti pensare alla funzione degli AirPods Pro che consente di accettare una chiamata annuendo o di rifiutarla scuotendo la testa. In quel caso, l'obiettivo è permettere un'interazione a mani libere o in contesti dove non si può parlare.

Qui, l'ambizione è molto più alta, perché per addestrare l'AI a comprendere i movimenti labiali unici di ogni persona, il sistema verrebbe allenato con dati audio e video. Il brevetto parla di registrazioni audio a diversi volumi, da un parlato normale (tra i 40 e i 70textdB) a un sussurro (tra i 20 e i 50textdB), abbinate a dati visivi della bocca da diverse angolazioni. Dietro questa innovazione c'è un nome noto in Apple, quello dell'inventore Paul X. Wang, già autore di numerosi brevetti legati anche a un possibile controller di gioco per lo stesso Vision Pro.

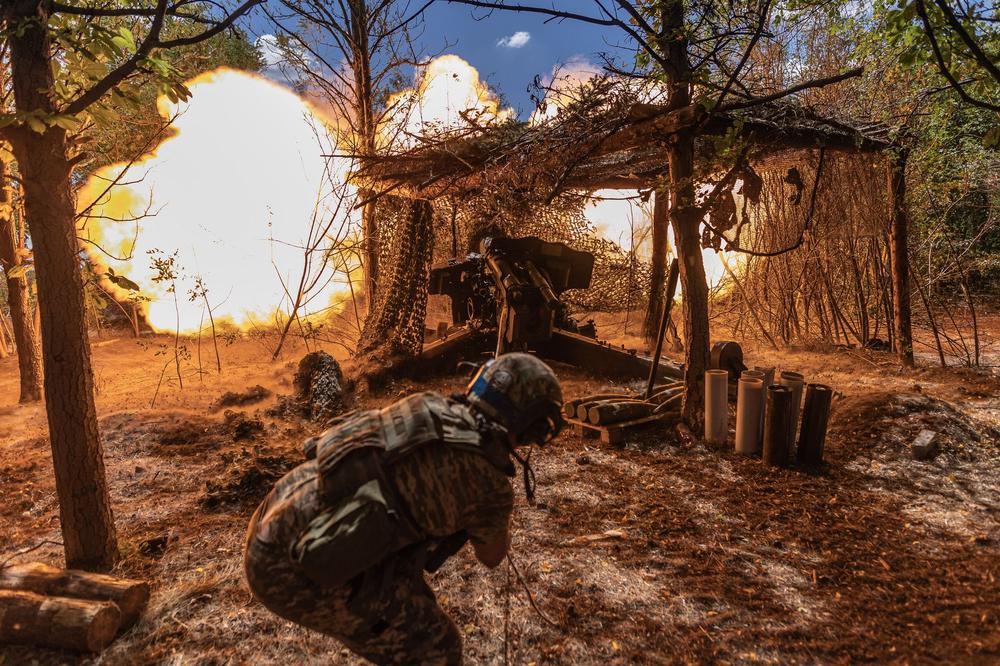

Over 70% of Ukrainians reject Russian peace plan, support for US proposal remains divisive, poll shows

Over 70% of Ukrainians reject Russian peace plan, support for US proposal remains divisive, poll shows